EMO是什么

EMO(Emote Portrait Alive)是一个由阿里巴巴集团智能计算研究院的研究人员开发的框架,一个音频驱动的AI肖像视频生成系统,能够通过输入单一的参考图像和语音音频,生成具有表现力的面部表情和各种头部姿势的视频。该系统能够捕捉到人类表情的细微差别和个体面部风格的多样性,从而生成高度逼真和富有表现力的动画。

EMO的官网入口

官方项目主页:https://humanaigc.github.io/emote-portrait-alive/

arXiv研究论文:https://arxiv.org/abs/2402.17485

GitHub:https://github.com/HumanAIGC/EMO(模型和源码待开源)

EMO的主要特点

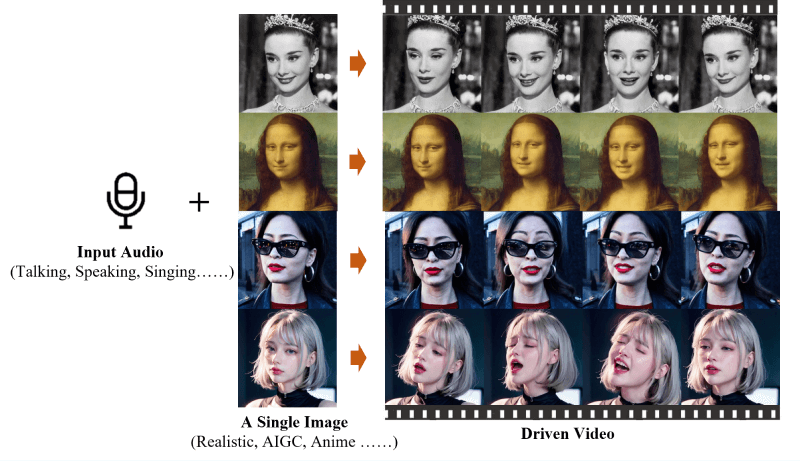

- 音频驱动的视频生成:EMO能够根据输入的音频(如说话或唱歌)直接生成视频,无需依赖于预先录制的视频片段或3D面部模型。

- 高表现力和逼真度:EMO生成的视频具有高度的表现力,能够捕捉并再现人类面部表情的细微差别,包括微妙的微表情,以及与音频节奏相匹配的头部运动。

- 无缝帧过渡:EMO确保视频帧之间的过渡自然流畅,避免了面部扭曲或帧间抖动的问题,从而提高了视频的整体质量。

- 身份保持:通过FrameEncoding模块,EMO能够在视频生成过程中保持角色身份的一致性,确保角色的外观与输入的参考图像保持一致。

- 稳定的控制机制:EMO采用了速度控制器和面部区域控制器等稳定控制机制,以增强视频生成过程中的稳定性,避免视频崩溃等问题。

- 灵活的视频时长:EMO可以根据输入音频的长度生成任意时长的视频,为用户提供了灵活的创作空间。

- 跨语言和跨风格:EMO的训练数据集涵盖了多种语言和风格,包括中文和英文,以及现实主义、动漫和3D风格,这使得EMO能够适应不同的文化和艺术风格。

腾讯推出的在线智能视频创作平台